CoRL2025

CoRL 부스들을 갔다와서 느낀 점 + 사진 + 미래의 나

느낀 점

- Actuator, Tactile Sensor, Hand, Arm, Full body, Quadruped, Physical AI 7개 카테고리

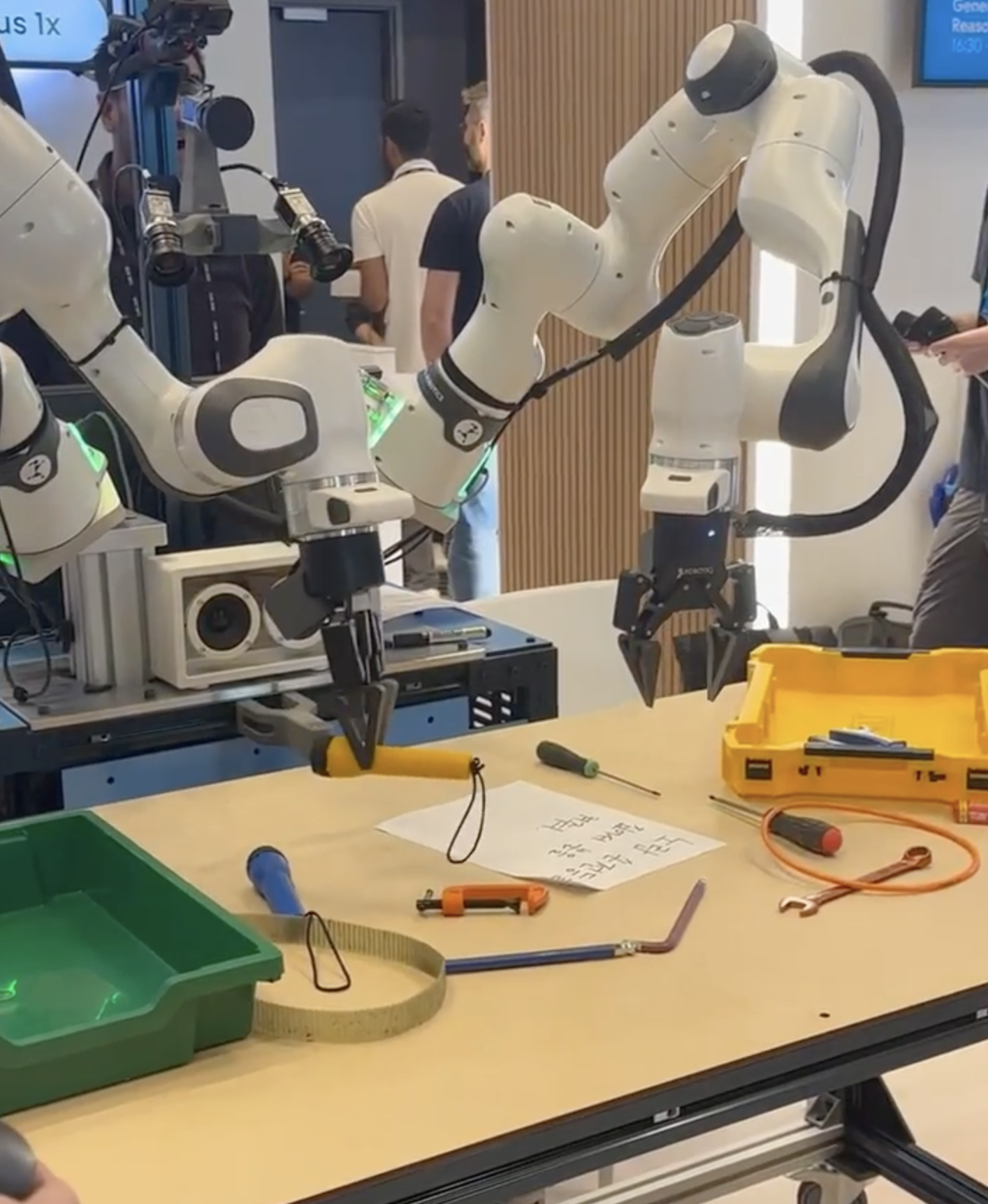

- low-level부터 high-level부터 다양하게 있고 hand, arm, full body, quadruped는 거의 다 teleoperation 혹은 정해진대로만 움직이는 로봇. Physical AI라고 볼 수 있는 건 Gemini Robotics만이 유일.

- Arm + Hand는 없었다. 모든 Arm의 gripper는 1 DoF. Arm + Hand 제어 및 텔레오퍼레이션이 어려워서 그런듯.

- Gemini Robotics 1.5가 ID 태스크는 매우 잘하나 OOD 태스크 요청하면 뇌정지와서 액션이 멈췄다.

- 연구와 데모는 또 다르다. 실제로 실행 가능하고 써볼 수 있는 데모는 연구보다 1-2년 늦다. 하지만 구글은 신이다. Gemini Robotics 1.5 나온지 얼마 되지도 않았는데 아주 안정적으로 데모가 동작한다.

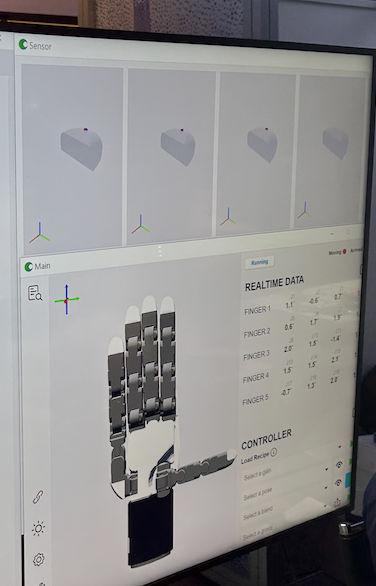

- 센서가 잔뜩 있는 장갑으로 손을 텔레오퍼레이션할 수 있다.

- 2cm x 2cm tactile 센서가 최소 50만원에서 최대 200만원까지 한다. 매우 비싸다. Full body robot은 억단위다. 이해가 간다! 생산 최적화해서 가격 낮추는 건 아예 또 다른 어려움이다. 거의 다 연구용이어서 이런 가격이어도 랩실에서 연구비 받아서 살 수 있다. 나는 생산용이라 이런 거 사기가 어렵다. 1-2개 사서 연구는 할 수 있지만 50만원 센서 사서 10만원에 팔 순 없으니까.... 결국 나는 어느 정도 직접 만들 생각 해야 한다!

- 자체 PCB 갖고 있는 곳이 대부분

- 대부분 회사의 BM은 랩실 혹은 회사 연구소에 납품하는 것. 실제 사람들에게 가치를 만들고 있는 곳은 없었다.

- 데모 사람들 다 옆에서 우분투 켜놓고 실시간 디버깅하고 고치고 로그 보면서 가슴 졸이는 거 보면서 감정이입이 많이 됐다.

사진들

Physical AI

0:00

/0:15

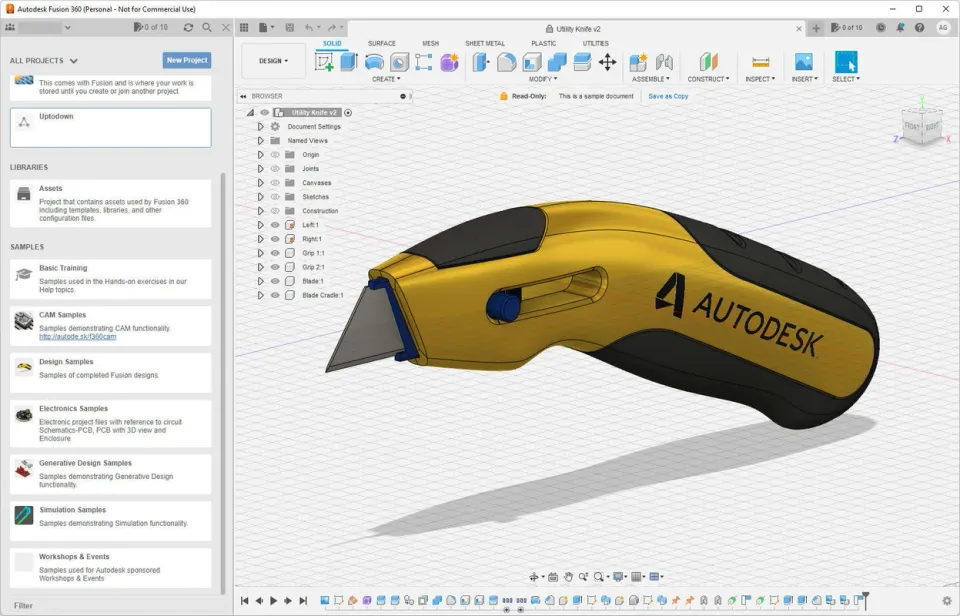

말로 명령 내리면 오디오로 답변하고 액션에 옮기는 Gemini Robotics 1.5

Full body

Quadruped

0:00

/0:08

Arm

0:00

/0:04

내가 직접 한 Arm Teleoperation (비디오엔 없지만 실제로 컵쌓기도 직접 했다. 아주 정교한 컨트롤이 필요하다.)

Hand

0:00

/0:06

Hand Teleoperation

Tactile Sensor

Actuator

미래의 나

- (Business) 책 넘기는 로봇부터 3-4단계를 차근차근 거쳐 최종적으로 휴머노이드까지. 중간 모든 제품들은 즉시 가치를 만들고 팔 수 있어야 함.

- 옵티머스처럼 한번에 범용성 갖춘 휴머노이드를 도전하는 게 맞는 걸지도 모르겠다는 생각이 들기도!

- (Data) Video, Human Action, AI Action

- Video + Human Action으로 Pretraining하고, human action으로 SFT하고, AI action으로 RL하고.

- (Training) Pretraining -> SFT -> RL in virtual -> RL in reality -> (Reasoning ?) -> (long context ?)

- LLM 학습할 때 corpus 모아놓고 next token prediction으로 pretraining하는 것처럼 기본적인 액션들만 쭉 수집하고 next action prediction으로 pretraining

- 태스크 주어지고 직접 텔레오퍼레이션하며 supervised fine tuning

- 가상환경(Isaac Sim)에서 RL

- 현실에서 RL

- 그 이후에 리즈닝, long context까지 도전해볼 수 있으면 좋겠다.

- (Input Modality) Vision -> Tactile -> Audio

- 촉각까지 multi-modal로 학습 잘 시켜보고 싶다! 눈 가리고 큐브 맞추는 것처럼 처음에 object 다 보여주고 눈 가리고 촉각만으로 태스크하는 거 보고 싶다.

- (Hardware) 조립 (Battery; 심장, Sensor; 감각기관, Actuator; 운동기관, Control Board; 뇌, Structure; 몸) -> Teleoperation (XR, glove, pose estimation w/ camera, etc.) -> Sensor 고도화 및 내재화 -> Actuator 고도화 및 내재화 -> 자체 PCB (Printed Control Board)

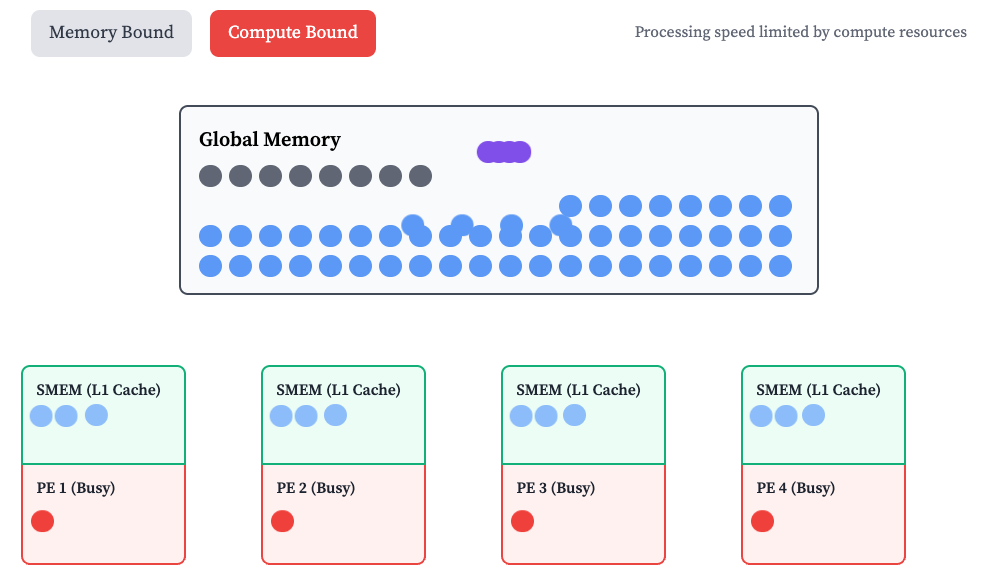

- (Infrastructure) GPU

- Simulation + Training

나중에 어디에서부터 하나씩 해볼지는 정확히 모르겠는데 각 차원별로는 이런 순서로 확장해나가기 시작할 것 같다.